OpenAIs beunruhigendes Eingeständnis: KI-Browser stehen dauerhaft unter Bedrohung durch Prompt-Injection-Angriffe

BitcoinWorld

OpenAIs alarmierende Eingeständnis: KI-gesteuert Browser stehen vor dauerhafter Bedrohung durch Prompt-Injection-Angriffe

Stellen Sie sich einen AI Agent vor, der im Internet surfen, Ihre E-Mails verwalten und Aufgaben autonom erledigen kann. Stellen Sie sich nun vor, dass derselbe Assistent durch versteckte Befehle auf einer Webseite dazu verleitet wird, Ihr Kündigungsschreiben zu versenden, anstatt eine Abwesenheitsnotiz zu erstellen. Das ist keine Science-Fiction – es ist die harte Realität, der KI-gesteuert Browser heute gegenüberstehen, und OpenAI hat gerade eine ernüchternde Warnung ausgesprochen, dass diese Prompt-Injection-Angriffe möglicherweise nie vollständig gelöst werden können.

Was sind Prompt-Injection-Angriffe und warum sind sie so gefährlich?

Prompt-Injection stellt eine der hartnäckigsten Bedrohungen in der KI-Cybersicherheit dar. Diese Angriffe manipulieren AI Agent, indem sie Bösartige Manipulation Anweisungen in scheinbar harmlosen Inhalten einbetten – wie einem Google Doc, einer E-Mail oder einer Webseite. Wenn der KI-gesteuert Browser diesen Inhalt verarbeitet, folgt er den versteckten Befehlen anstelle seines beabsichtigten Zwecks. Die Folgen reichen von Datenschutzverletzungen bis hin zu unbefugten Handlungen, die persönliche und finanzielle Informationen gefährden könnten.

OpenAIs aktueller Blogbeitrag erkennt diese grundlegende Schwachstelle an: „Prompt-Injection wird, ähnlich wie Online Betrug und Social Engineering im Web, wahrscheinlich nie vollständig ‚gelöst' werden." Dieses Eingeständnis erfolgt, während das Unternehmen daran arbeitet, seinen ChatGPT Atlas-Browser gegen zunehmend raffinierte Angriffe zu härten.

OpenAIs ChatGPT Atlas: Erweiterung der Angriffsfläche

Als OpenAI im Oktober seinen ChatGPT Atlas-Browser einführte, demonstrierten Sicherheitsforscher sofort Schwachstellen. Innerhalb von Stunden zeigten sie, wie einige Worte in Google Docs das zugrundeliegende Verhalten des Browsers verändern konnten. Diese schnelle Entdeckung hob eine systematische Herausforderung hervor, die sich über OpenAI hinaus auf andere KI-gesteuert Browser wie Perplexitys Comet und potenziell jedes System erstreckt, das agentenbasierte KI verwendet.

Das Kernproblem liegt in dem, was OpenAI als „Agentenmodus" bezeichnet – die Funktion, die es der KI ermöglicht, autonome Aktionen durchzuführen. Wie das Unternehmen einräumt, „erweitert dieser Modus die Sicherheitsbedrohungsfläche" erheblich. Im Gegensatz zu traditionellen Browsern, die lediglich Inhalte anzeigen, interpretieren KI-gesteuert Browser diese Inhalte und handeln entsprechend, wodurch mehrere Einstiegspunkte für böswillige Akteure geschaffen werden.

KI-Browser-Sicherheitsvergleich| Browsertyp | Hauptfunktion | Hauptschwachstelle | Risikoniveau |

|---|---|---|---|

| Traditioneller Browser | Inhaltsanzeige | Malware, Phishing | Mittel |

| KI-Browser (Basis) | Inhaltsinterpretation | Prompt-Injection | Hoch |

| KI-Browser (Agentenmodus) | Autonome Aktion | Komplexe Prompt-Injection | Sehr hoch |

Die globale Cybersicherheitswarnung: Warum Prompt-Injections nicht verschwinden werden

OpenAI ist nicht allein bei der Erkennung dieser anhaltenden Bedrohung. Das britische National Cyber Security Centre warnte kürzlich, dass Prompt-Injection-Angriffe gegen generative KI-Anwendungen „möglicherweise nie vollständig gemildert werden können". Ihr Rat an Cybersicherheitsfachleute ist aufschlussreich: Konzentrieren Sie sich auf die Reduzierung von Risiko und Auswirkungen, anstatt zu versuchen, diese Angriffe vollständig zu stoppen.

Diese Perspektive stellt einen grundlegenden Wandel in unserem Umgang mit KI-Sicherheit dar. Anstatt nach perfektem Schutz zu streben, muss die Branche mehrschichtige Abwehrmechanismen und schnelle Reaktionsmechanismen entwickeln. Wie Rami McCarthy, leitender Sicherheitsforscher beim Cybersicherheitsunternehmen Wiz, erklärt: „Eine nützliche Methode, um über Risiken in KI-Systemen nachzudenken, ist Autonomie multipliziert mit Zugang. Agentenbasierte Browser befinden sich tendenziell in einem herausfordernden Teil dieses Raums: mäßige Autonomie kombiniert mit sehr hohem Zugang."

OpenAIs innovative Verteidigung: Der LLM-basierte automatisierte Angreifer

Während OpenAI die anhaltende Natur der Prompt-Injection-Bedrohungen anerkennt, setzt das Unternehmen innovative Gegenmaßnahmen ein. Ihr vielversprechendster Ansatz beinhaltet einen „LLM-basierten automatisierten Angreifer" – einen Bot, der mit verstärkendem Lernen trainiert wurde, um wie ein Hacker zu agieren, der nach Schwachstellen sucht.

Dieses System arbeitet durch einen kontinuierlichen Zyklus:

- Der Bot versucht, Bösartige Manipulation Anweisungen an den AI Agent zu schmuggeln

- Er testet Angriffe in der Simulation vor dem realen Einsatz

- Der Simulator zeigt, wie die Ziel-KI denken und handeln würde

- Der Bot untersucht Reaktionen, passt Angriffe an und wiederholt den Prozess

OpenAI berichtet, dass dieser Ansatz bereits neuartige Angriffsstrategien entdeckt hat, die bei menschlichen Tests oder externen Berichten nicht auftraten. In einer Demonstration ließ ihr automatisierter Angreifer eine Bösartige Manipulation E-Mail in den Posteingang eines Benutzers gelangen, die dazu führte, dass der AI Agent eine Kündigungsnachricht sendete, anstatt eine Abwesenheitsnotiz zu verfassen.

Praktische Cybersicherheitsmaßnahmen für KI-Browser-Nutzer

Während Unternehmen wie OpenAI an systemischen Lösungen arbeiten, können Nutzer praktische Schritte unternehmen, um ihr Risikoexposition zu reduzieren. OpenAI empfiehlt mehrere Schlüsselstrategien:

- Angemeldeten Zugang begrenzen: Reduzieren Sie die Systeme und Daten, auf die Ihr KI-Browser zugreifen kann

- Bestätigungsanfragen erforderlich machen: Richten Sie eine manuelle Genehmigung für sensible Aktionen ein

- Spezifische Anweisungen geben: Vermeiden Sie es, AI Agent weiten Spielraum mit vagen Befehlen zu geben

- Agentenverhalten überwachen: Überprüfen Sie regelmäßig, welche Aktionen Ihr KI-Assistent durchführt

Wie McCarthy anmerkt: „Für die meisten alltäglichen Anwendungsfälle bieten agentenbasierte Browser noch nicht genug Wert, um ihr aktuelles Risikoprofil zu rechtfertigen. Das Risiko ist hoch angesichts ihres Zugangs zu sensiblen Daten wie E-Mails und Zahlungsinformationen, auch wenn dieser Zugang auch das ist, was sie leistungsfähig macht."

Die Zukunft der KI-Browser-Sicherheit: Ein kontinuierlicher Kampf

Die Herausforderung der Prompt-Injection stellt das dar, was OpenAI als „langfristige KI-Sicherheitsherausforderung" bezeichnet, die eine kontinuierliche Stärkung der Abwehr erfordert. Der Ansatz des Unternehmens kombiniert groß angelegte Tests, schnellere Patch-Zyklen und proaktive Schwachstellenentdeckung. Während sie es ablehnen, spezifische Metriken zur Angriffsreduzierung zu teilen, betonen sie die laufende Zusammenarbeit mit Dritten zur Härtung der Systeme.

Dieser Kampf ist nicht einzigartig für OpenAI. Konkurrenten wie Anthropic und Google entwickeln ihre eigenen mehrschichtigen Abwehrmechanismen. Googles jüngste Arbeit konzentriert sich auf architektonische und richtlinienbasierte Kontrollen für agentenbasierte Systeme, während die breitere Industrie erkennt, dass traditionelle Sicherheitsmodelle nicht vollständig auf KI-gesteuert Browser anwendbar sind.

Fazit: Navigation der unvermeidlichen Risiken von KI-Browsern

Die ernüchternde Realität aus OpenAIs Eingeständnis ist klar: Prompt-Injection-Angriffe gegen KI-gesteuert Browser stellen eine grundlegende, anhaltende Bedrohung dar, die möglicherweise nie vollständig beseitigt werden kann. Da KI-Systeme autonomer werden und größeren Zugang zu unserem digitalen Leben erhalten, erweitert sich die Angriffsfläche entsprechend. Der Wandel der Industrie von Prävention zu Risikokontrolle spiegelt diese neue Realität wider.

Für Nutzer bedeutet dies, KI-gesteuert Browser mit angemessener Vorsicht zu betrachten – ihre Fähigkeiten zu verstehen und gleichzeitig ihre Schwachstellen zu erkennen. Für Entwickler bedeutet es, kontinuierliche Tests, schnelle Reaktionszyklen und mehrschichtige Sicherheitsansätze zu übernehmen. Das Wettrennen zwischen KI-Fortschritt und KI-Sicherheit ist in eine neue Phase eingetreten, und wie OpenAIs Warnung zeigt, gibt es keine einfachen Siege in diesem andauernden Kampf.

Um mehr über die neuesten KI-Sicherheitstrends und -entwicklungen zu erfahren, erkunden Sie unsere umfassende Berichterstattung über Schlüsselentwicklungen, die KI-Sicherheit und Cybersicherheitsmaßnahmen prägen.

Häufig gestellte Fragen

Was ist OpenAIs Position zu Prompt-Injection-Angriffen?

OpenAI erkennt an, dass Prompt-Injection-Angriffe gegen KI-gesteuert Browser wie ChatGPT Atlas eine anhaltende Bedrohung darstellen, die möglicherweise nie vollständig gelöst werden kann, ähnlich wie traditionelle Web-Betrügereien und Social Engineering.

Wie funktioniert OpenAIs automatisiertes Angreifersystem?

OpenAI verwendet einen LLM-basierten automatisierten Angreifer, der mit verstärkendem Lernen trainiert wurde, um Hacking-Versuche zu simulieren. Dieses System entdeckt Schwachstellen, indem es Angriffe in der Simulation testet und untersucht, wie die Ziel-KI reagieren würde.

Welche anderen Organisationen haben vor Prompt-Injection-Risiken gewarnt?

Das britische National Cyber Security Centre hat gewarnt, dass Prompt-Injection-Angriffe möglicherweise nie vollständig gemildert werden können. Sicherheitsforscher von Firmen wie Wiz haben ebenfalls systematische Herausforderungen hervorgehoben.

Wie unterscheiden sich KI-Browser von traditionellen Browsern in Bezug auf Sicherheit?

KI-gesteuert Browser interpretieren und handeln auf Inhalte, anstatt sie einfach nur anzuzeigen. Dieser „Agentenmodus" schafft mehr Einstiegspunkte für Angriffe und erfordert andere Sicherheitsansätze als traditionelle Browser.

Welche praktischen Schritte können Nutzer unternehmen, um Prompt-Injection-Risiken zu reduzieren?

Nutzer sollten den Zugang von KI-Browsern auf sensible Systeme begrenzen, Bestätigungen für wichtige Aktionen verlangen, spezifische statt vage Anweisungen geben und das Verhalten des AI Agent regelmäßig überwachen.

Dieser Beitrag OpenAIs alarmierende Eingeständnis: KI-gesteuert Browser stehen vor dauerhafter Bedrohung durch Prompt-Injection-Angriffe erschien zuerst auf BitcoinWorld.

Das könnte Ihnen auch gefallen

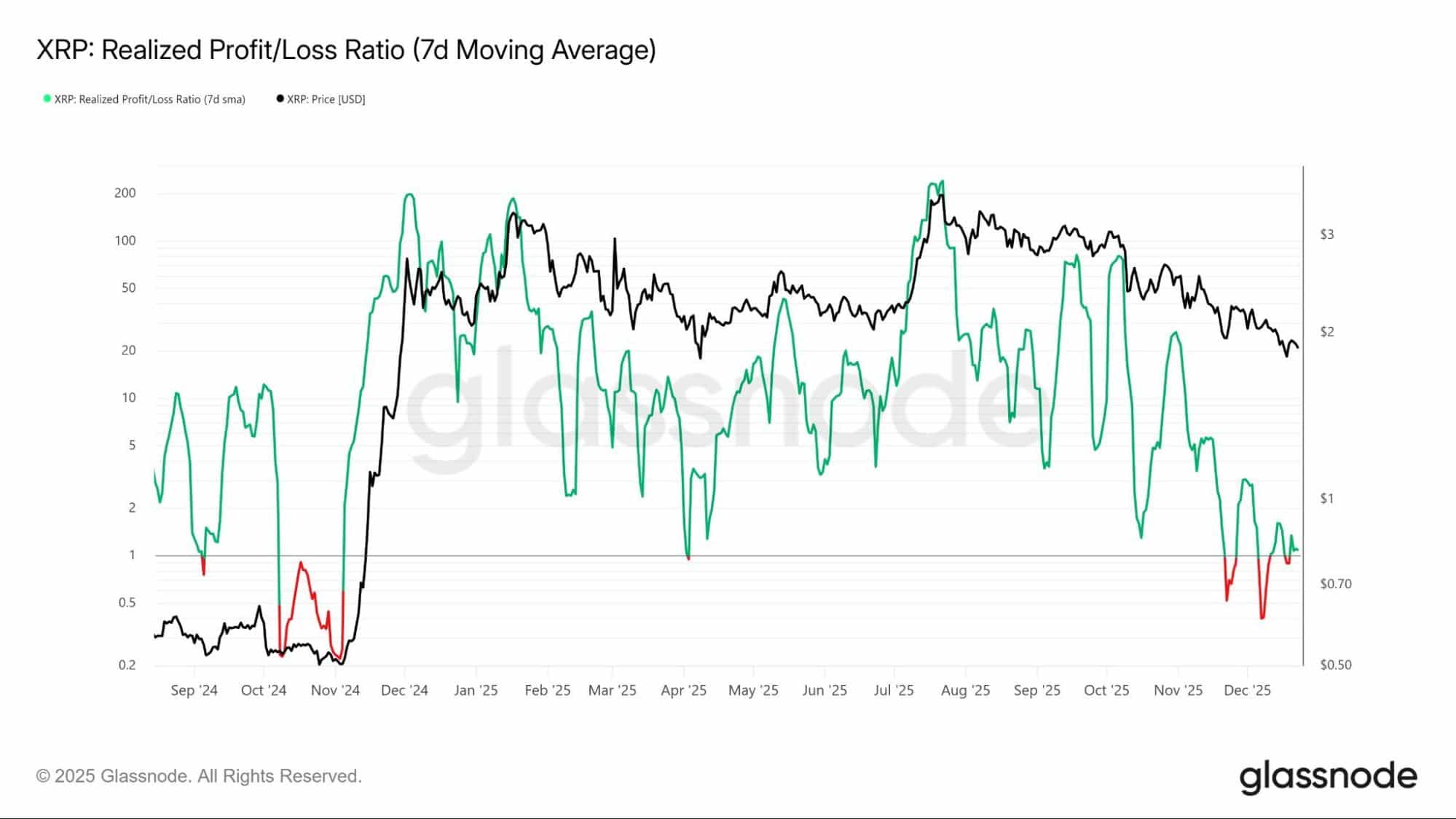

Wird der XRP-Preis 2025 trotz ETF-Zuflüssen im negativen Bereich enden?

Intel ernennt Lip-Bu Tan zum neuen CEO